7.6 KiB

HOWTO: Lokaal een LLM / AI draaien op je computer

Introductie

Om AI te gebruiken hoef je niet noodzakelijk een website of een app van ChatGPT, Microsoft of Google te gebruiken. Het is mogelijk om lokaal op je eigen PC een LLM (Large Language Model) te draaien zonder dat je gegevens worden gedeeld met een andere partij. Zo'n lokale LLM kun je vaak op verschillende manieren benaderen zoals:

- Via een applicatie.

- een webpagina,

- command line.

- API

Hieronder zullen enkele opties worden besproken.

Software om een LLM lokaal te draaien

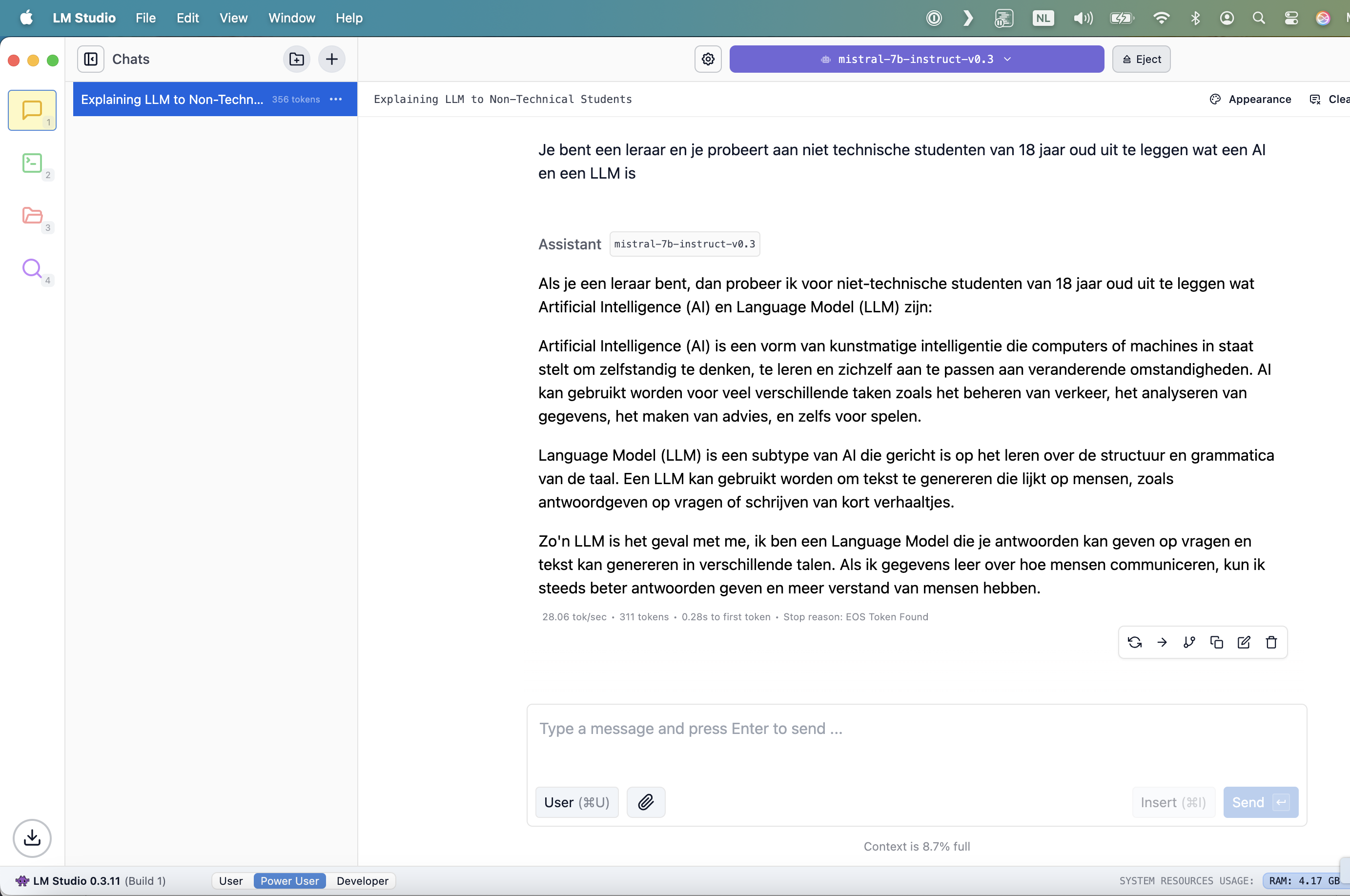

LM Studio

LM Studio is een handige tool waarmee je lokale Large Language Models (LLMs) kunt ontdekken, downloaden en uitvoeren op je eigen computer. Het biedt een gebruiksvriendelijke interface en ondersteunt verschillende modellen, zoals Llama en DeepSeek. Het werkt volledig offline, wat betekent dat je gegevens privé blijven op je apparaat.

Het installeren van LM Studio is vrij eenvoudig! Hier zijn de stappen:

- Download de software: Bezoek de officiële website van LM Studio en download de versie die geschikt is voor jouw besturingssysteem (Windows, macOS of Linux).

- Start de installatie: Open het gedownloade installatiebestand en volg de instructies op het scherm.

- Controleer de vereisten: Zorg ervoor dat je computer voldoet aan de minimale systeemvereisten, zoals minimaal 16 GB RAM en een CPU met AVX2-ondersteuning.

- Open LM Studio: Na de installatie kun je de applicatie starten en beginnen met het ontdekken en downloaden van modellen.

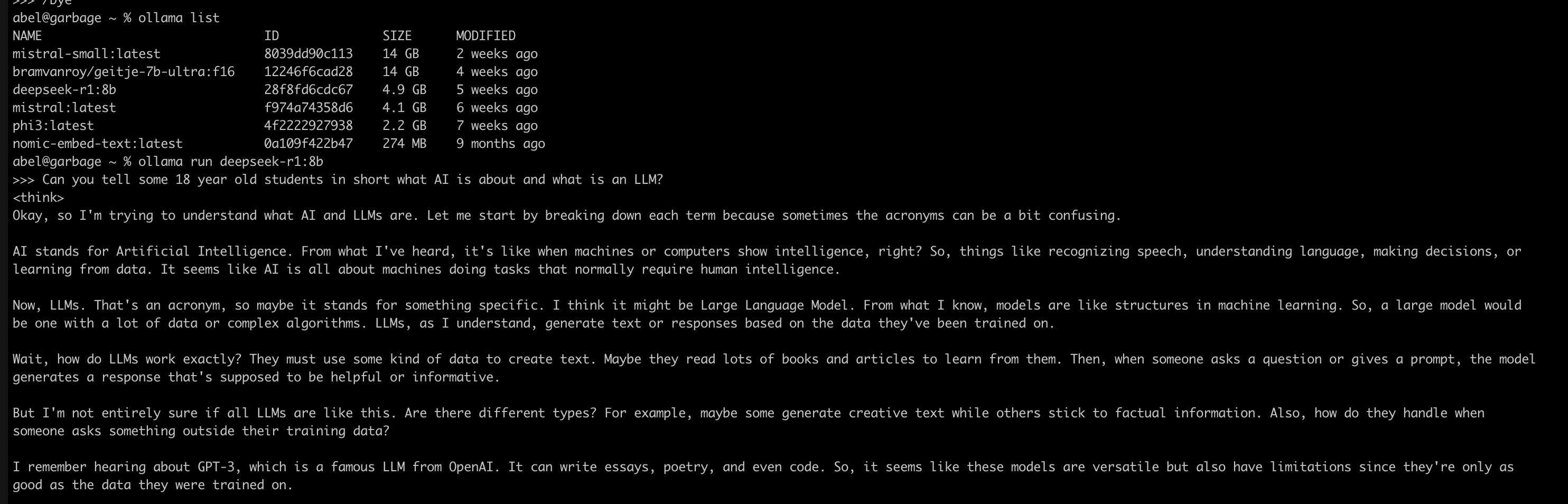

Ollama

Ollama is een platform waarmee je krachtige Large Language Models (LLMs) lokaal op je computer kunt draaien. Het biedt een gebruiksvriendelijke interface, ondersteunt verschillende modellen en waarborgt je privacy doordat het volledig offline kan werken.

Ollama wordt vaak geinstalleerd in combinatie met Open WebUI.

Het installeren van Ollama is eenvoudig en hangt af van je besturingssysteem. Hier zijn de algemene stappen:

- Download Ollama: Ga naar de officiële website van Ollama en download de versie die geschikt is voor jouw besturingssysteem (Windows, macOS of Linux).

- Installeer de software:

- Windows: Open het installatiebestand en volg de instructies. Voor Windows-gebruikers wordt vaak aangeraden om WSL (Windows Subsystem for Linux) te gebruiken.

- macOS: Gebruik Homebrew door het commando brew install ollama in de terminal te typen.

- Linux: Voer het volgende commando uit in de terminal: curl -fsSL https://ollama.ai/install.sh | sh.

- Controleer de installatie: Typ ollama --version in de terminal om te controleren of de installatie succesvol is.

- Download een model: Gebruik bijvoorbeeld het commando ollama pull llama2-7b om een model te downloaden.

- Start een model: Typ ollama run llama2-7b om het model te starten en ermee te communiceren.

Alternatieve kun je ollama ook via Docker draaien, met MacOS is dit echter niet aan te raden aangezien de gpu dan niet kan worden gebruikt.

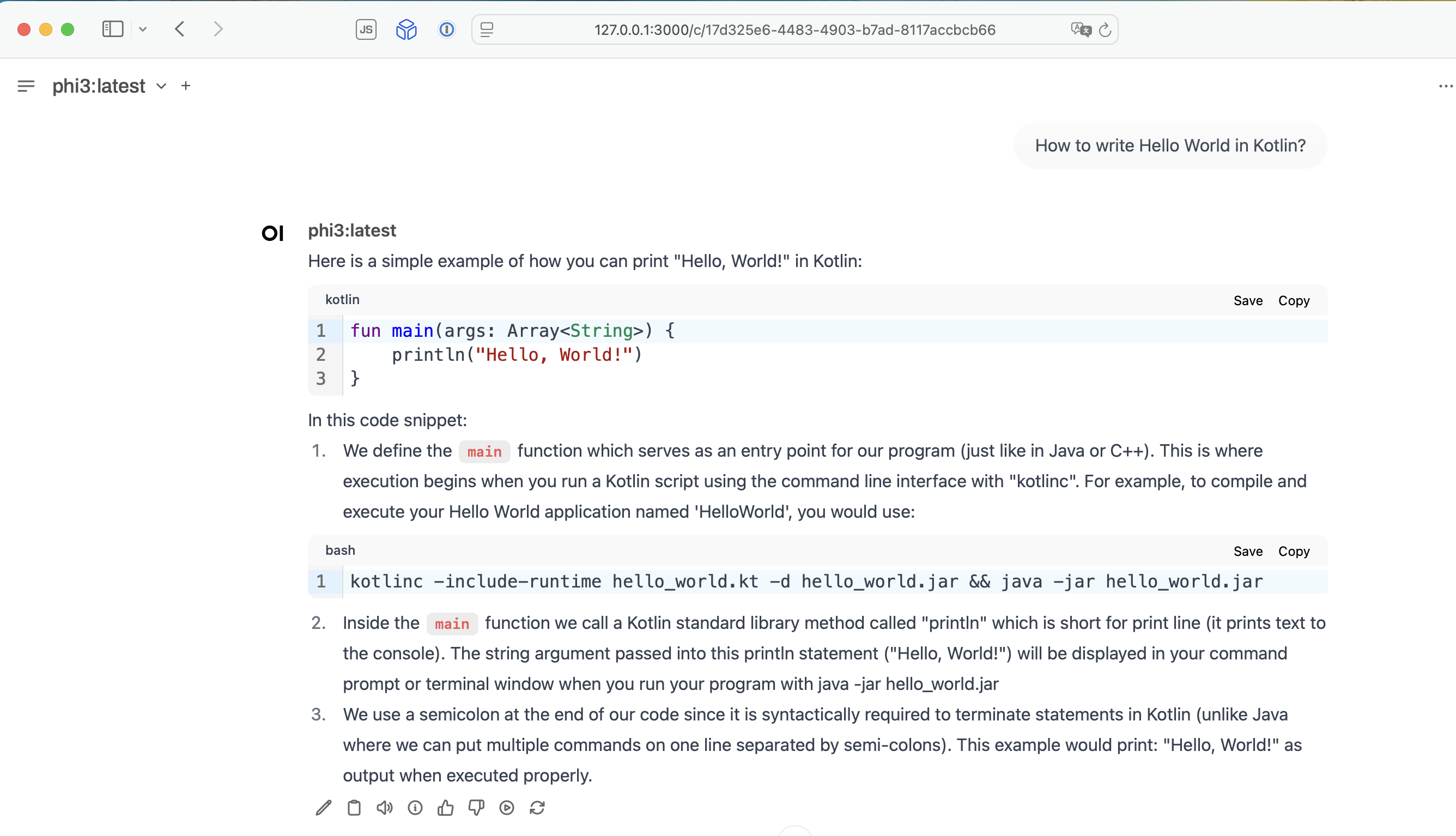

Open WebUI

Open WebUI is een gebruiksvriendelijke interface die je helpt om lokale Large Language Models (LLMs) te beheren en uit te voeren. Het biedt een visuele manier om met modellen te werken, ondersteunt meerdere platforms zoals Ollama, en draait volledig lokaal, wat zorgt voor maximale privacy. Het is ontworpen om toegankelijk te zijn, zelfs voor gebruikers zonder technische achtergrond.

Ollama heeft standaard een API draaien op poort 11434. Open webgui probeert standaard te connecten naar een 127.0.0.1 op deze poort. Open WebUI kan zelf geen LLM draaien, maar je kunt er wel bijvoorbeeld een codeqwen, llama of andere llm mee installeren in Ollama (wat dus via de APi gaat).

Installatie met Docker (aanbevolen)

- Installeer Docker: Download en installeer Docker via de officiële website.

- Download de Open WebUI Docker-image:

docker pull ghcr.io/open-webui/open-webui:main

- Start de container:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

- Toegang tot de interface: Open je browser en ga naar http://localhost:3000.

Installatie met Python

- Installeer Python: Zorg ervoor dat Python 3.8 of hoger is geïnstalleerd.

- Installeer Open WebUI

pip install open-webui

- Start Open WebUI:

open-webui

- Toegang tot de interface: Open je browser en ga naar http://localhost:3000.

RAG (Retrieval-Augmented Generation)

RAG voor Retrieval-Augmented Generation. Het is een techniek die Large Language Models (LLMs) combineert met geavanceerde zoekmogelijkheden om nauwkeurigere en contextueel relevante antwoorden te genereren. Hier is hoe het werkt:

- Informatie ophalen: Wanneer een gebruiker een vraag stelt, zoekt het systeem in een externe kennisbron (zoals een database of documenten) naar relevante informatie.

- Generatie verbeteren: De opgehaalde informatie wordt toegevoegd aan de prompt die naar het LLM wordt gestuurd. Dit helpt het model om antwoorden te genereren die gebaseerd zijn op actuele en specifieke gegevens.

- Voordelen: -Nauwkeurigheid: Het vermindert de kans op "hallucinaties" (onjuiste antwoorden) door het model te baseren op echte gegevens.

- Flexibiliteit: Het kan worden toegepast op domeinspecifieke kennis, zoals juridische documenten of technische handleidingen.

- Up-to-date informatie: Omdat het informatie in real-time ophaalt, blijft het relevant, zelfs als de kennisbasis verandert.

RAG wordt vaak gebruikt in toepassingen zoals klantenservice, juridische analyse en andere domeinen waar nauwkeurigheid en context cruciaal zijn.

Met een RAG kun je dus eigen informatie toevoegen. Je kunt dit doen via bijvoorbeeld een Python script maar er zijn ook programma's voor zoals AnythingLLM

Open WebUI

- In Open WebUI, klik linksbovenin op Workspace

- In de Knowledge tab, klik (+) button op Kennis / Knowledge.

- Geef een naam en omschrijving en klip op Create Knowledge.

- Klik nu op de nieuw aangemaakte Knowledge en voeg je documenten toe met de (+) button aan het begin van het zoek veld en upload files.

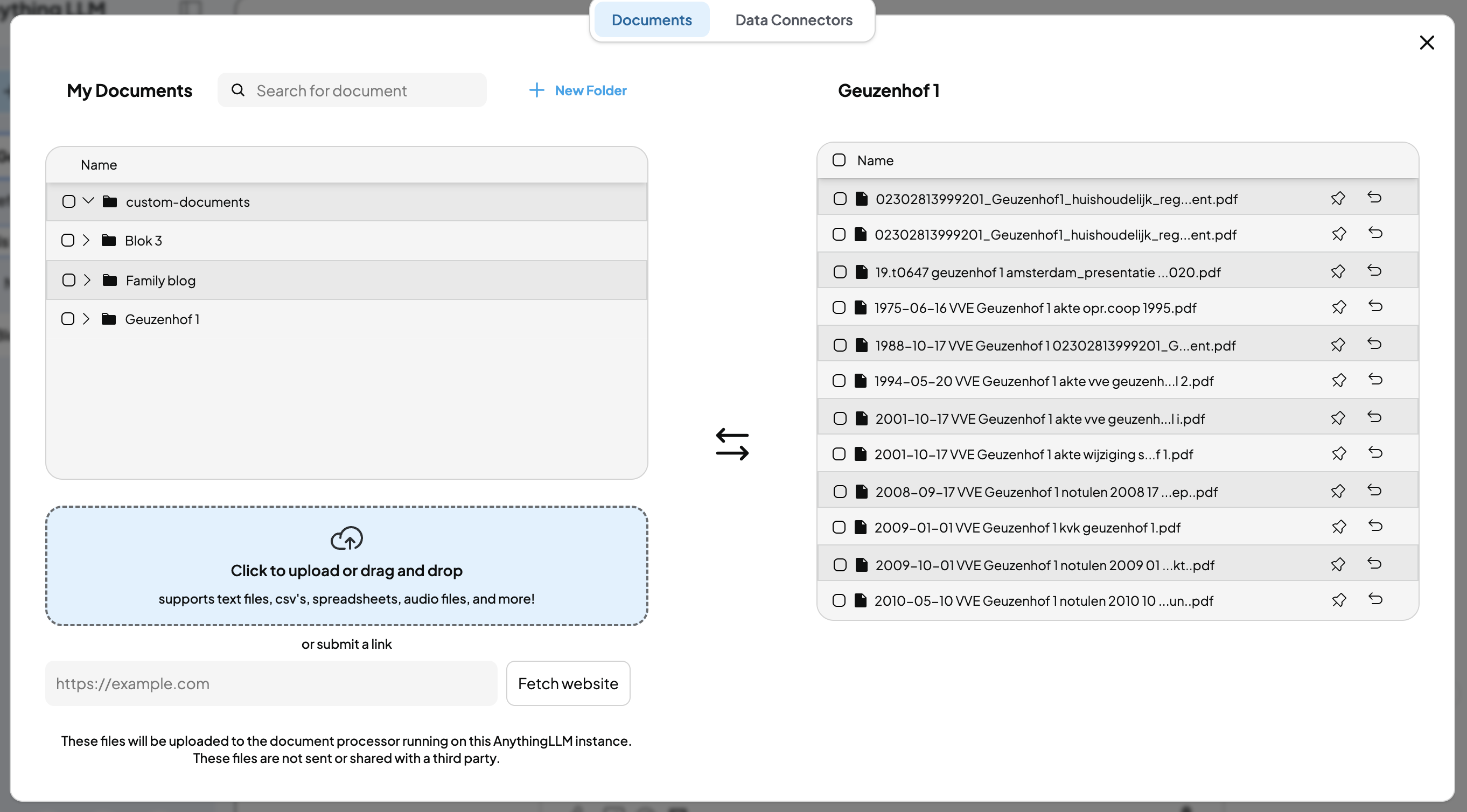

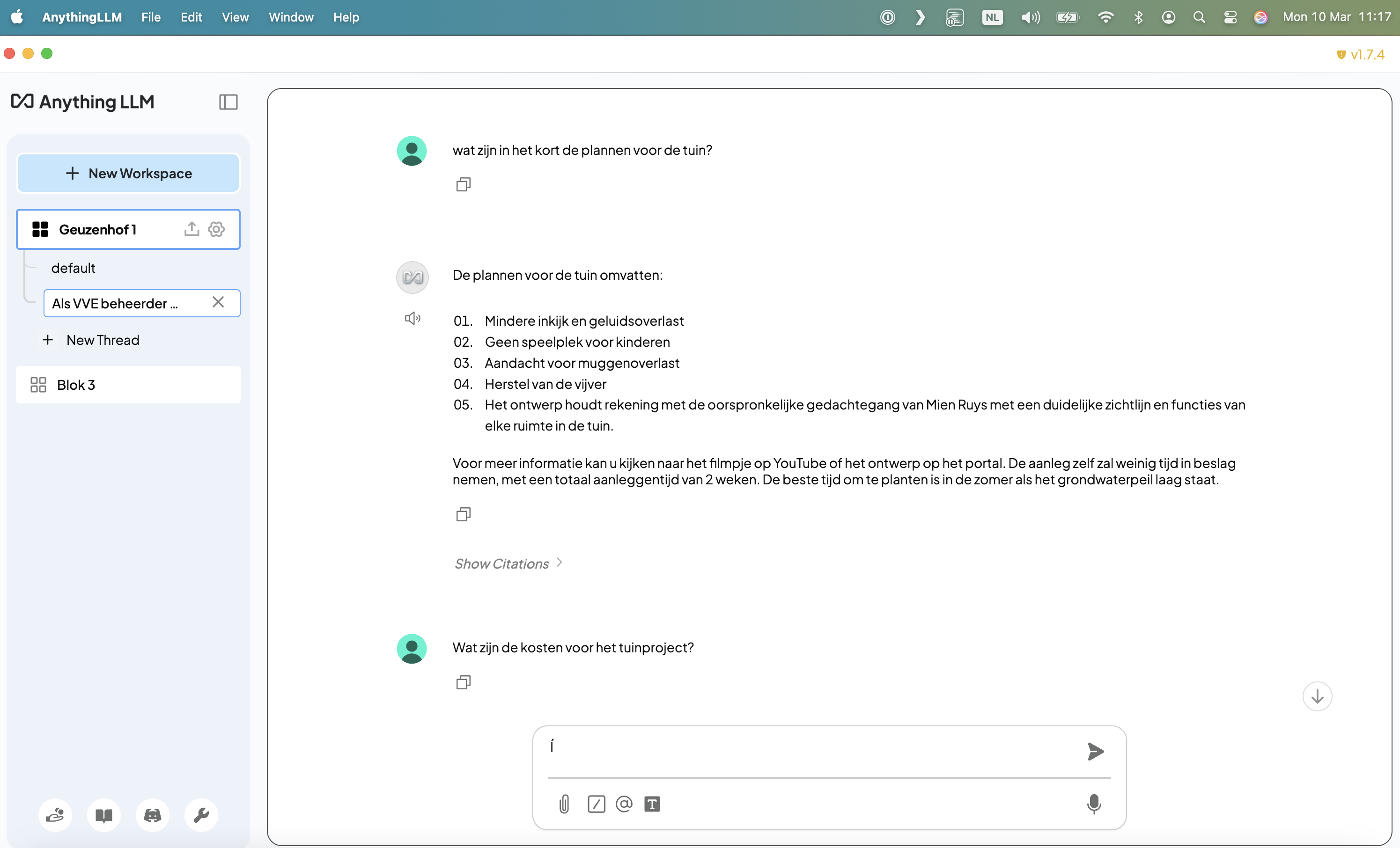

AnythingLLM

AnythingLLM is een veelzijdige AI-toepassing waarmee je krachtige Large Language Models (LLMs) lokaal kunt draaien op je computer. Het biedt een gebruiksvriendelijke interface en ondersteunt functies zoals:

- Documentbeheer: Chatten met documenten zoals PDF's, Word-bestanden en codebases.

- AI Agents: Creëer en gebruik AI-agents zonder codeervaardigheden.

- Privacy: Alles draait lokaal, dus je gegevens blijven privé.

- Multi-model ondersteuning: Werkt met zowel open-source als commerciële LLMs.

- Open Source: Het is gratis en aanpasbaar, zodat je het kunt uitbreiden met eigen functies.

Je kunt AnythingLLM koppelen met je LM Studio of ollama installatie.

PrivateGPT

https://github.com/zylon-ai/private-gpt

PrivateGPT is een AI-project dat ontworpen is om volledig privé te werken, zonder dat gegevens je eigen omgeving verlaten. Het stelt gebruikers in staat om vragen te stellen over hun documenten met behulp van krachtige Large Language Models (LLMs), zelfs zonder internetverbinding2.

Het biedt een API die kan worden geïntegreerd in toepassingen en ondersteunt zowel normale als streaming-antwoorden. PrivateGPT is ideaal voor bedrijven die privacy hoog in het vaandel hebben staan, omdat het werkt zonder persoonlijke gegevens te delen met externe systemen

Prompt Engineering (TO-DO)

Voorbeeld: "You are a teacher for 18 year old students. Try to limit your answers to a maximum of 5 separate paragraphs and answer in Dutch only. Every paragraph should start with an emoji".